2024 年人工智能推理基础设施状况调查亮点

2025 年 2 月 26 日 • 作者:Sherlock Xu

随着人工智能成为现代商业的基石,组织在基础设施策略方面面临着至关重要的决策。这些决策涵盖从利用托管 API 到开发内部解决方案。作为用于构建和扩展 AI 应用的统一推理平台BentoML 的创建者,我们的目标是帮助组织做出明智的基础设施决策。为了提供数据驱动的见解,我们从 2024 年 12 月中旬到 2025 年 1 月中旬进行了一项综合调查。该调查收集了来自不同行业的 250 多名参与者的见解,探讨了部署模式、模型使用和基础设施挑战等主题。我们的调查结果详细载于2024 年人工智能推理基础设施状况调查报告中。

本文介绍了报告的主要发现,并提供了可行的建议,以帮助组织改进其 AI 基础设施策略。如需个性化指导,请咨询我们的专家或参与我们的Slack 社区,AI 从业者在此交流经验和最佳实践。

执行摘要

我们的分析揭示了当前 AI 基础设施采用和实施状况的四个主要发现

-

大多数组织处于其 AI 之旅的早期阶段。许多公司专注于构建基础 AI 能力。他们使用的模型数量有限,并投入大量资源用于数据准备、训练和开发。基础工作对于创建可扩展和可持续的 AI 解决方案至关重要。

-

混合部署和多模型策略正在兴起。虽然无服务器 API 端点被广泛使用,但组织越来越多地将其与定制解决方案相结合。这种混合方法也扩展到模型选择,公司正在利用各种模型,例如 LLMs 和多模态模型。

-

正在转向开源和微调模型。开源模型正引领着采用趋势,组织对其进行微调以执行特定任务,以更低的成本获得更好的性能。这一转变表明人们越来越希望在 AI 解决方案中获得更多控制权和定制性。

-

关键基础设施挑战集中在三个主要领域

- 部署和维护的复杂性

- GPU 的可用性和定价

- 隐私和安全问题

这些挑战凸显了对能够简化 AI 基础设施管理同时确保更好的隐私实践的工具的需求。此外,对更高级模型(例如 LLMs 和多模态模型)日益增长的需求正在推动对中高端 GPU 的需求。

现在,让我们更仔细地看看这些主要发现。

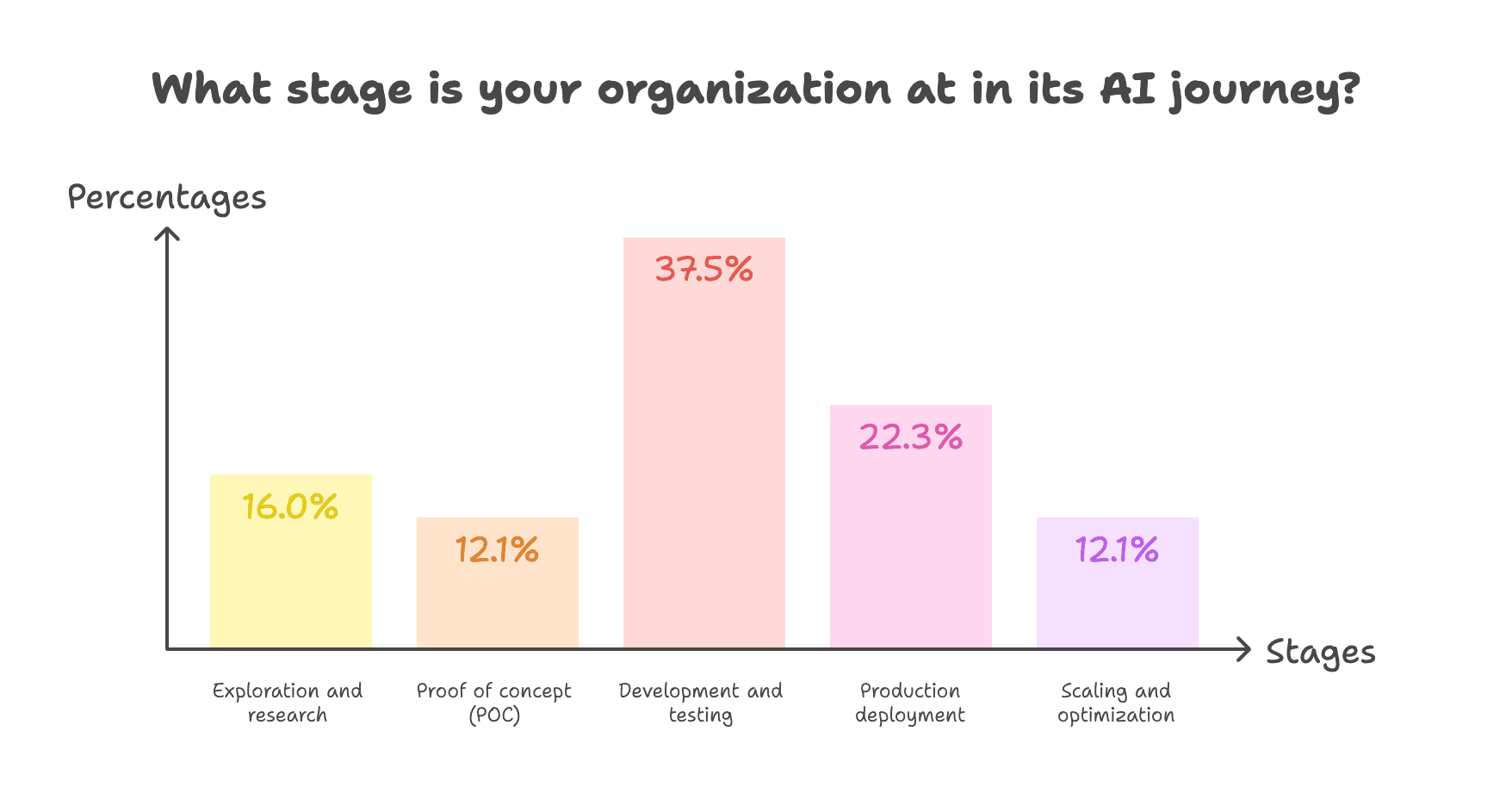

AI 成熟度:聚焦基础建设

我们的调查显示,大多数组织在进入全面生产之前仍在建立其 AI 基础。

成熟度水平分为三个主要类别

- 早期阶段 (28.1%):16.0% 的组织仍处于探索和研究阶段,而 12.1% 正在开展概念验证项目。

- 开发和测试 (37.5%):这是最大的群体,占受访组织的三分之一以上。

- 高级阶段 (34.4%):在更成熟的阶段中,22.3% 已进入生产部署,12.1% 专注于扩展和优化。

尽管相当一部分组织已达到高级阶段,但大多数仍在努力巩固其基础。这种分布反映了 AI 实施的复杂性以及在进入生产之前建立坚实基础的重要性。

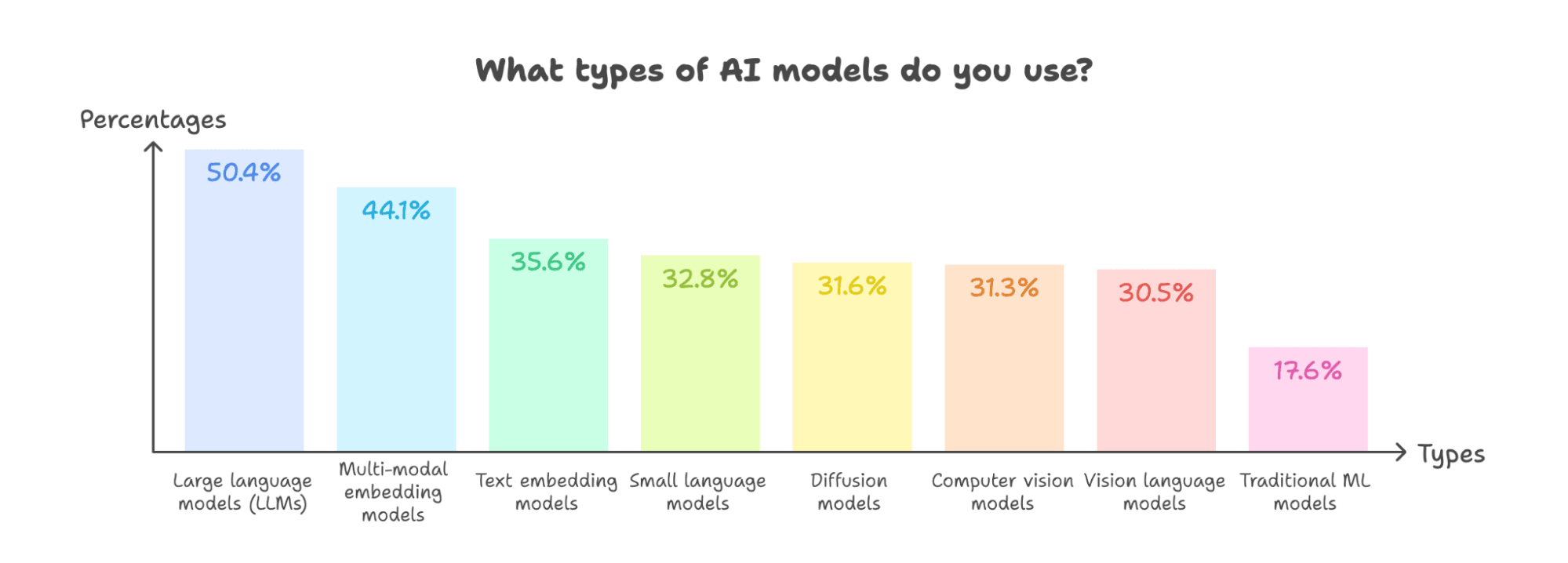

LLMs 和多模态 AI 的主导地位

我们的调查显示,人们明显偏爱生成式 AI,尤其是能够提供更丰富、更动态用户体验的模型。混合模型策略的出现反映了对灵活解决方案日益增长的需求,以应对复杂、多方面的挑战。

-

LLMs 以 50.4% 的采用率领先,确立了其作为现代 AI 应用支柱的地位。这种领先地位可能源于它们在为 RAG 和 AI 代理等高级系统提供动力方面的关键作用。

-

多模态能力也获得了显著关注:

- 多模态嵌入模型以 44.1% 的比例位居第二。

- 计算机视觉模型和视觉语言模型的采用率各占三分之一左右(分别为 31.3% 和 30.5%)。

这些统计数据表明,组织正在将 AI 应用扩展到基于文本的领域之外。这一趋势印证了我们关于多模态 AI 的预测,其中新兴的交互模式(例如 ChatGPT 中的视频聊天)正在改变用户体验。这些新模态不仅代表额外的功能,还代表着与 AI 互动方式的全新方式。

-

组织正在采用混合模型策略。绝大多数 (80.1%) 使用不止一种模型类型,超过半数 (52.0%) 正在实施三种或更多类型。这意味着组织正在结合不同的 AI 能力来应对各种用例和需求。

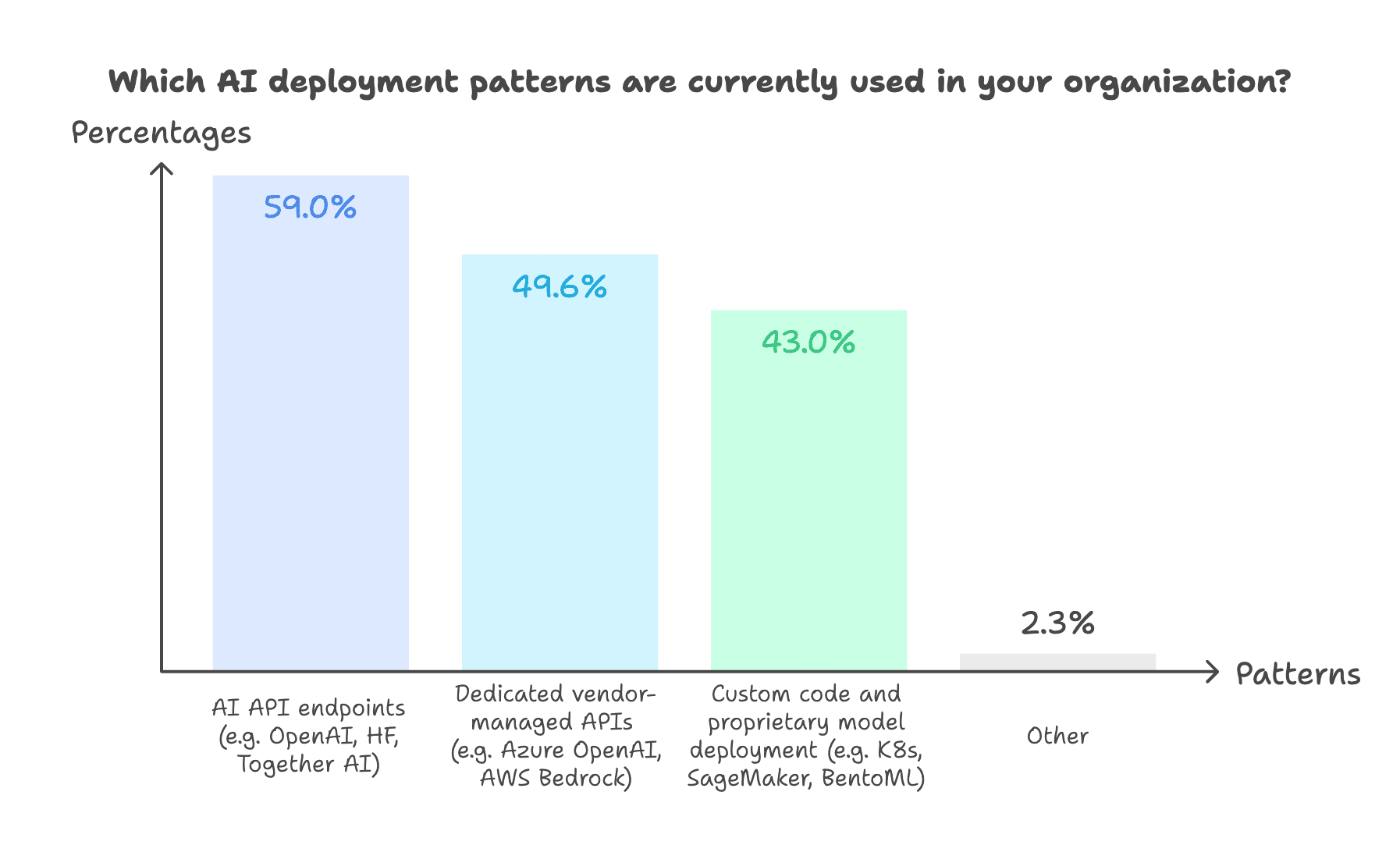

部署趋势:从 API 优先到混合策略

调查显示,人们明显偏好 API 优先的部署策略。然而,结合多种部署方法的混合方法也正在兴起。

- API 优先部署占据主导地位。59.0% 的受访者依靠 AI API 端点(例如 OpenAI、Hugging Face、Together AI)进行 AI 部署。值得注意的是,其中 80.8% 是中小型公司(员工少于 500 人)。这一趋势可能源于 AI API 允许资源有限的组织快速利用先进的 AI 能力。摆脱基础设施开发和维护的复杂性,组织可以加快 AI 产品的部署。

- 混合部署策略正在出现。在使用 AI API 端点的组织中,40.4% 也使用专有的供应商托管 API,33.8% 选择自定义代码和专有模型部署。这表明一些公司正在对 AI 基础设施采取一种务实的多层方法。他们力求在托管 API 的便捷性和定制解决方案的适应性之间取得平衡。

-

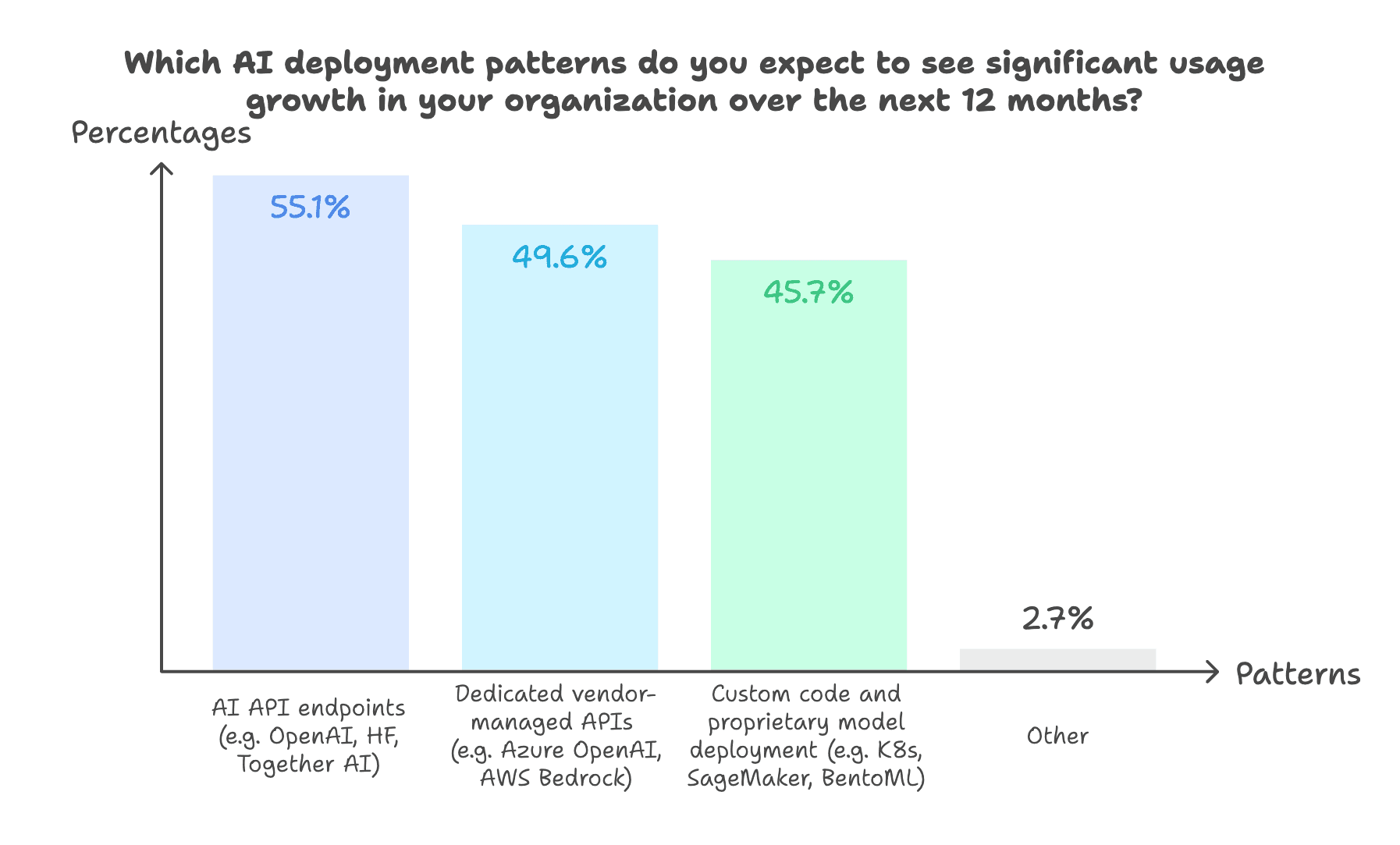

所有部署模式预计都将强劲增长.

- 55.1% 的受访者预计 AI API 端点的使用将显著增长。

- 49.6% 预计专用供应商托管 API 的采用率会提高。

- 46.9% 预测在未来一年内,多种部署选项(即选择多种部署模式)的采用率将会上升。

虽然 API 优先方法仍然是大多数组织的重点,但一些组织也在探索混合策略。这可能意味着在 AI 领域,放之四海而皆准的解决方案很少见。组织很可能在构建定制的长期基础设施能力的同时,利用简单的基于 API 的解决方案来满足当前需求。

请参阅我们的博客文章,了解有关无服务器部署和专用部署之间选择的更多信息。

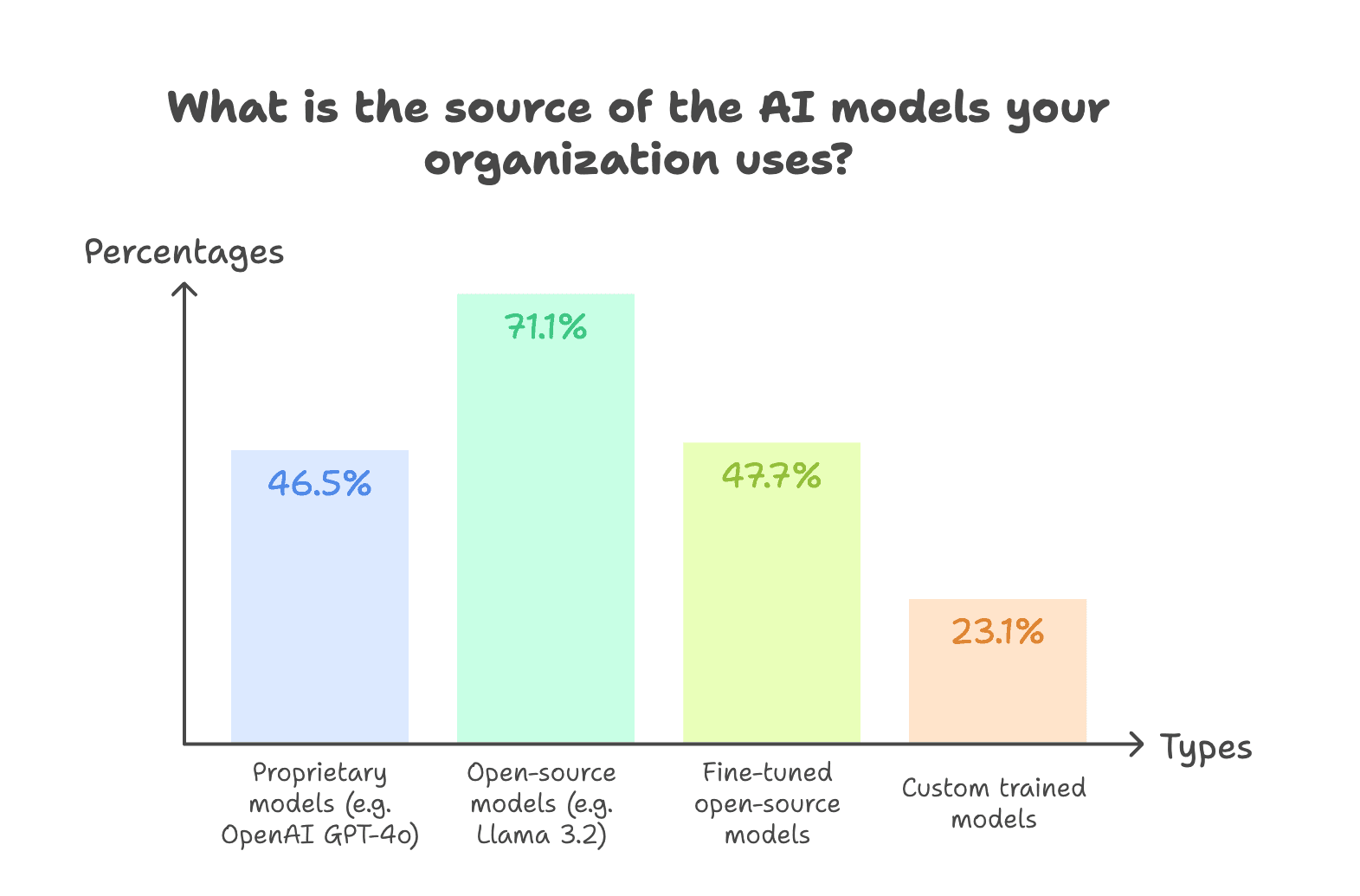

开源模型和微调模型日益流行

更多组织正在采用混合模型策略,这表明正明显转向开源和定制 AI 解决方案。开源模型处于采用的最前沿。超过 70% 的受访者报告使用开源模型,表明对控制权和定制性的强烈偏好。这一趋势似乎是由开源模型的快速发展推动的,例如DeepSeek R1 和 Llama 3.1 405B。它们在特定任务上与专有模型之间的性能差距正在稳步缩小。

- 混合模型采用很普遍。约 63.3% 的受访者同时使用专有、开源和定制模型。这使他们能够根据特定的用例和需求,利用不同类型模型的优势。

- 微调模型正在获得动力。近一半的受访者 (47.7%) 微调开源模型。这意味着组织正在努力为特定任务定制 AI 模型,以优化性能,同时保持对其解决方案的控制。

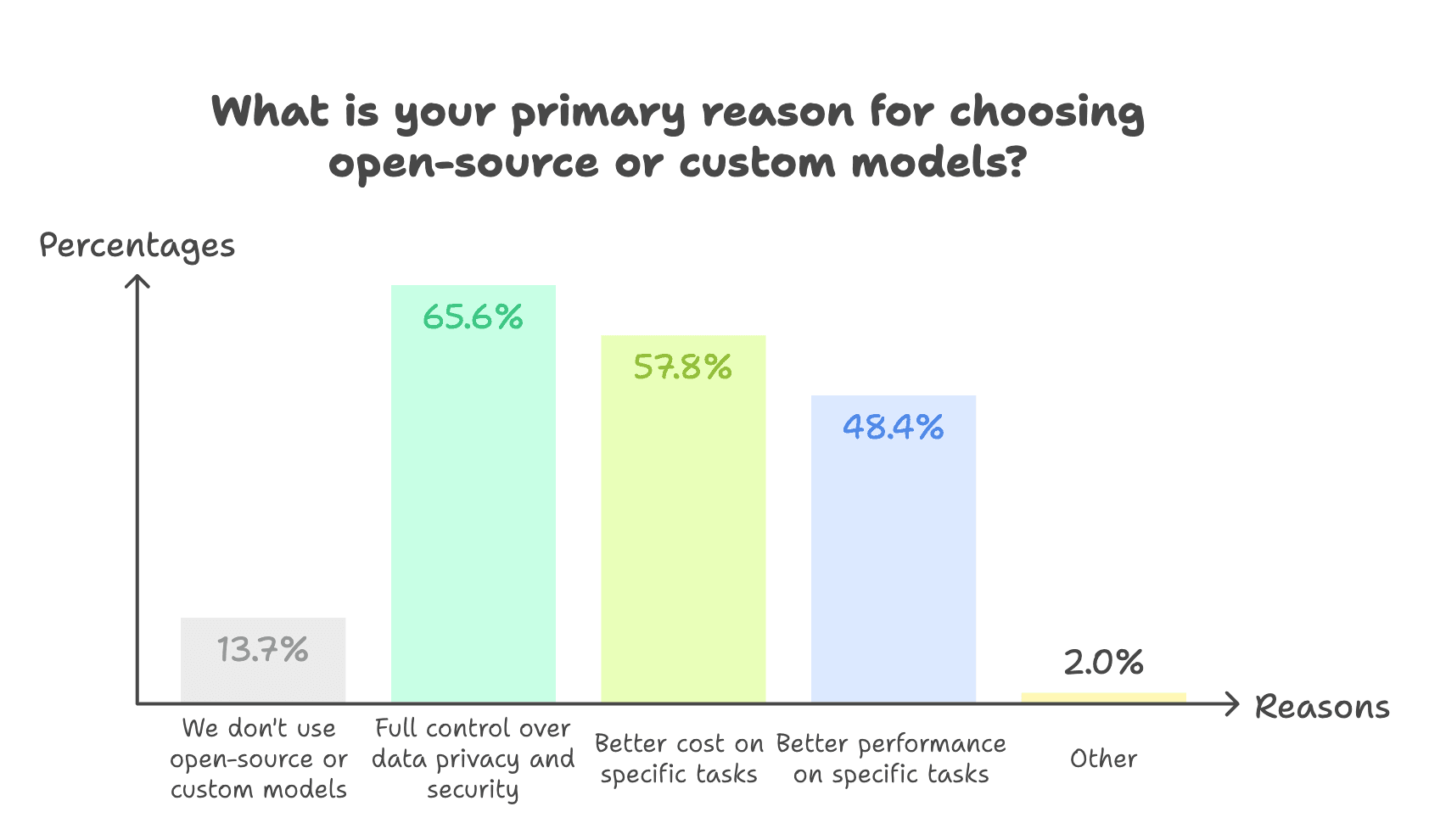

- 数据隐私和控制是关键驱动因素。65.6% 的受访者将完全控制数据和隐私列为选择开源或定制模型的主要原因。这些优势使组织能够

-

保持对其数据的所有权。

- 创建满足其独特需求的定制 AI 解决方案。

- 在特定任务上实现更好的成本/性能比。

- 这些结果表明,组织正在对模型选择采取战略性方法。他们寻求针对每项任务采用最佳工具,而不是依赖于万能解决方案。通过平衡专有模型和开源模型,他们可以

保持灵活性,同时避免供应商锁定。

- 确保持续获取最新的 AI 进展。

- 获得先发优势并保持竞争优势。

- AI 基础设施中的关键挑战

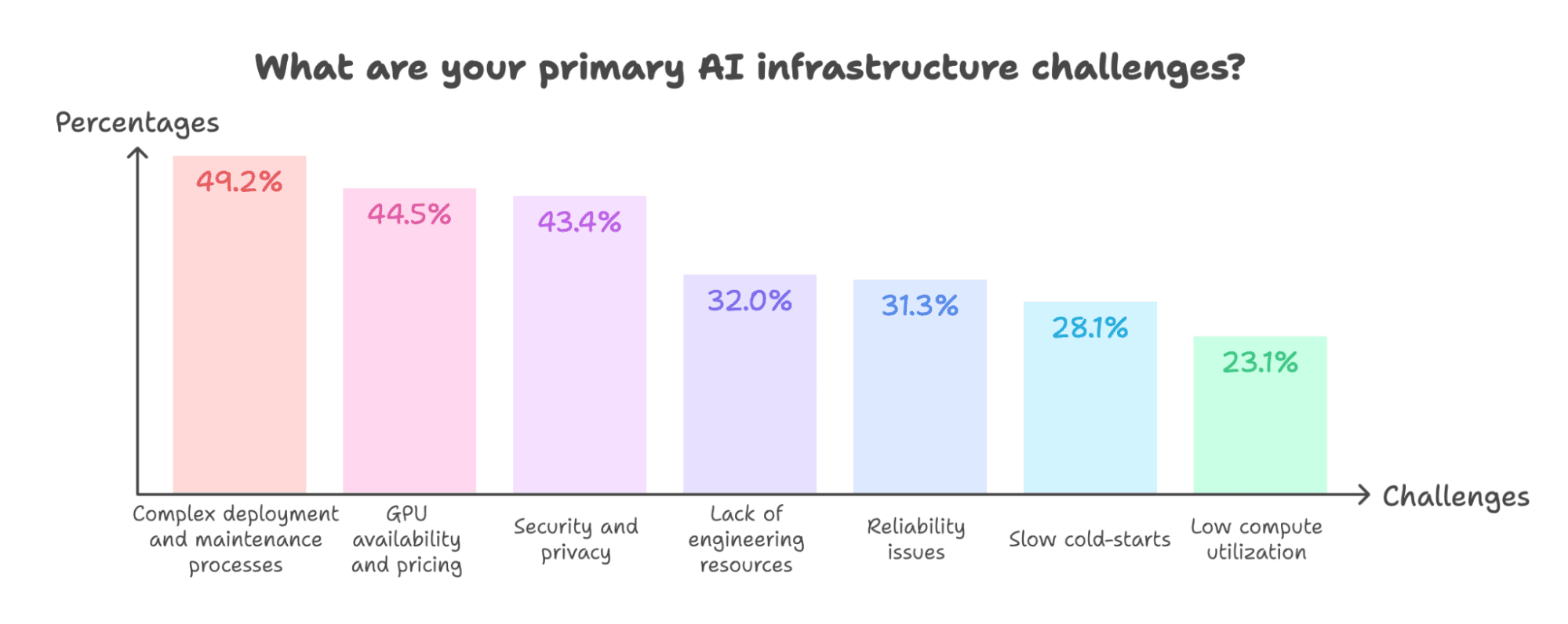

组织在 AI 基础设施方面面临若干挑战,其中部署复杂性、GPU 资源和安全性是首要关注点。

部署复杂性是最大的挑战,49.2% 的受访者将其列为主要障碍。这凸显了 AI 系统的技术复杂性,例如与现有基础设施集成以及管理多个模型管道。这也意味着组织需要简化基础设施管理并降低 AI 采用复杂性的工具。这与我们之前的发现相呼应:AI API 端点的广泛使用反映了避免这些复杂性的愿望。

- GPU 的可用性和定价是另一个关键挑战,影响了 44.5% 的受访者。这凸显了随着 AI 模型采用持续增长,计算需求不断升级。此外,它强调了对更灵活的基础设施解决方案的需求,例如具有多云支持的平台。此类平台应使组织能够选择最适合其特定用例的 GPU 可用性和定价的云提供商。

- 安全和隐私是 43.4% 组织的首要关注点。对数据保护日益增长的关注可能会推动对自带云 (BYOC) 等安全基础设施解决方案的更大需求。

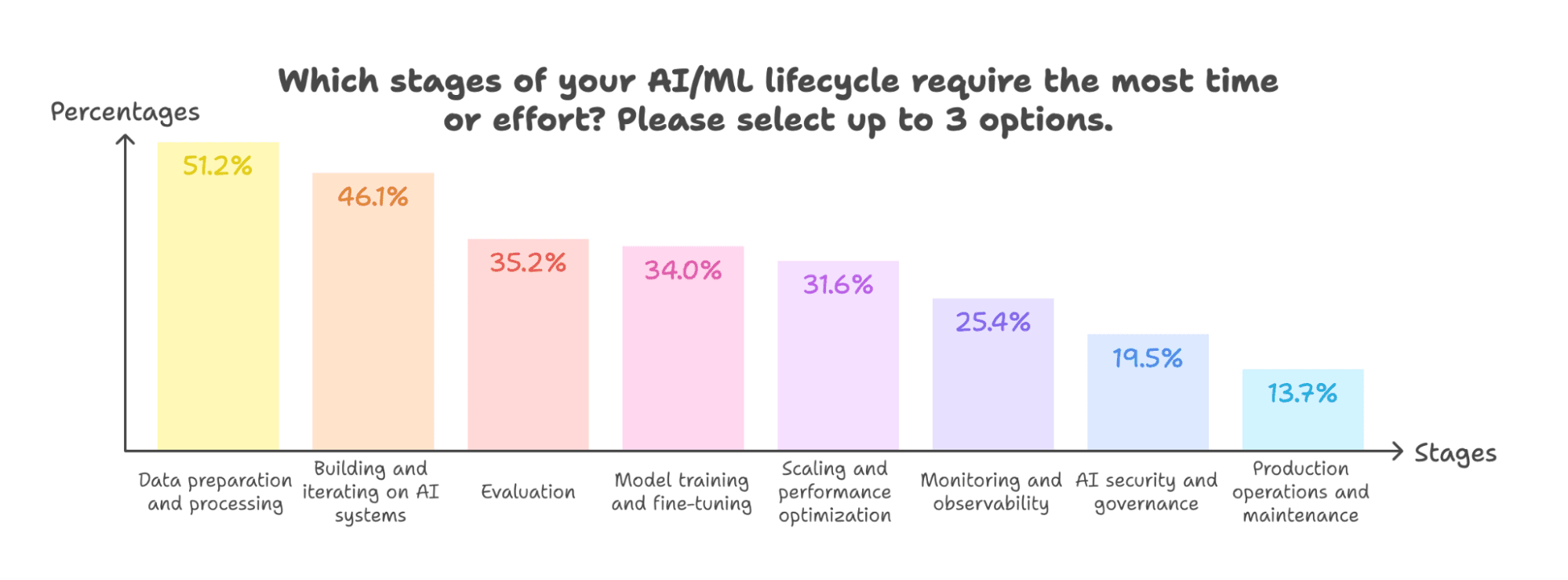

- 数据准备和处理仍然是最耗时的阶段 (51.2%)。这凸显了管理和清理数据管道的困难。与我们之前的发现类似,这表明许多组织仍在专注于建立坚实的 AI 基础。

- 构建和迭代系统是第二大重要工作 (46.1%)。这表明需要能够加速模型迭代和部署的工具,从而实现更快的实验和优化。

- 很明显,许多组织仍在为其 AI 计划奠定基础。随着他们迈向生产阶段,他们需要更好的工具来简化部署、迭代和整体基础设施管理。此外,一些组织还需要能够简化模型训练、微调、可观测性、安全性和运维的解决方案。

多样化的基础设施格局:从云端到本地

公共云采用占主导地位

-

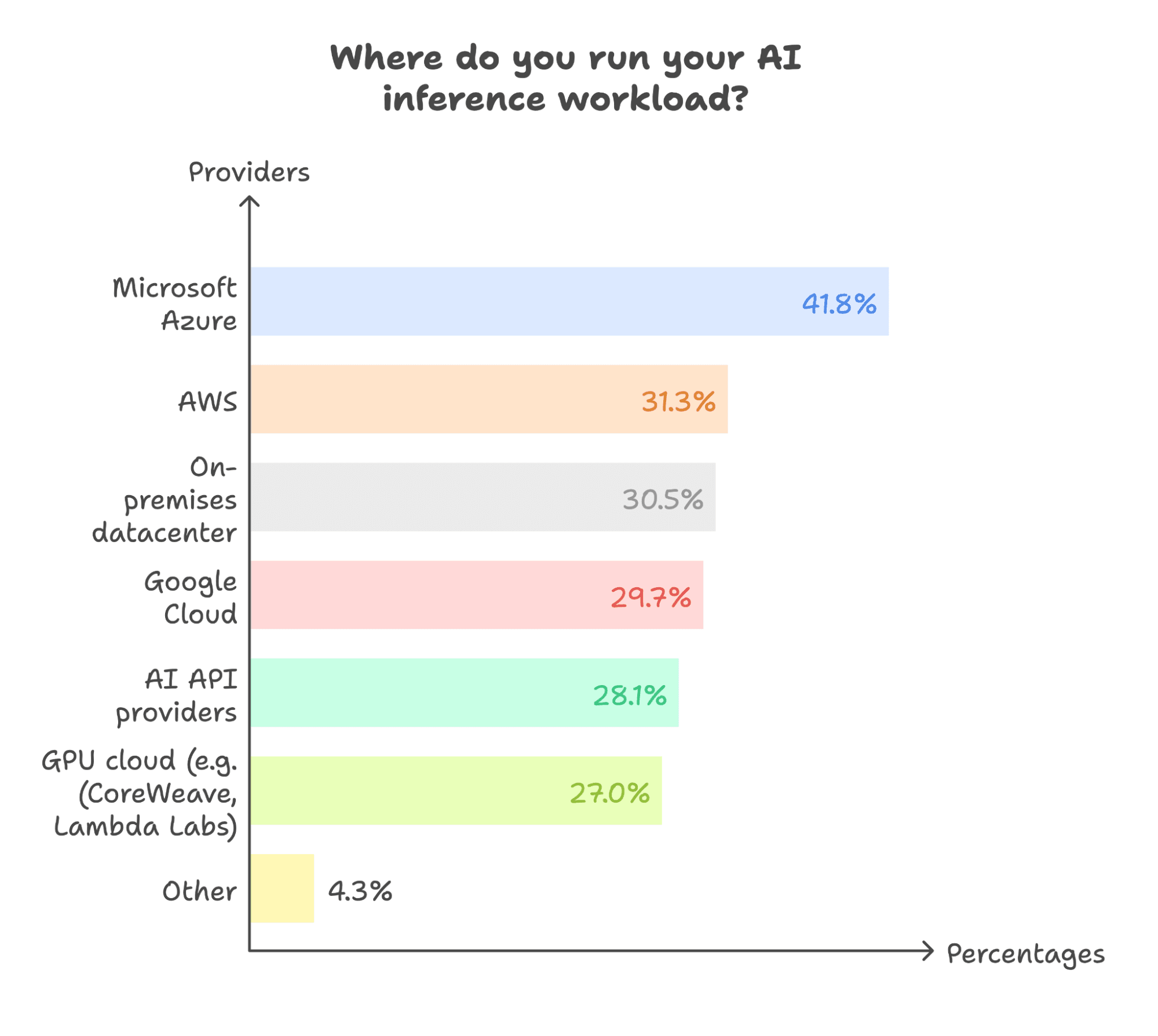

Microsoft Azure 使用率最高 (41.8%),但竞争依然激烈。其他提供商的采用率也相似,差距不大:AWS 占 31.3%,本地部署占 30.5%,Google Cloud 占 29.7%。

- 值得注意的是,77.3% 的受访者至少在一个公共云(AWS、Google Cloud 或 Microsoft Azure)上运行其 AI 推理工作负载。其中,25.3% 使用至少两个公共云,另有 25.3% 将公共云与本地部署结合使用。这表明一些组织正在采用多云策略或混合云和本地解决方案,以优化成本、性能和控制。

- 多提供商策略普遍存在:高达 62.1% 的受访者在多个环境中运行推理,这反映了向混合基础设施发展的日益增长的趋势。这种方法使组织能够利用各个云提供商提供的独特优势,包括定价优势、GPU 可用性以及专业的 AI 服务。

-

建议

根据调查结果,以下是我们对实施 AI 解决方案的组织提出的关键建议

在部署策略中平衡速度和控制。托管 API 端点非常适合快速原型设计和快速获得结果。它们可以在无需管理基础设施开销的情况下实现快速部署和实验。然而,为了保持竞争力,投资于自定义代码和模型部署至关重要。结合这些方法有助于减少供应商依赖性,并为您提供对系统的更大控制权。

- 利用开源和定制模型以获得更大的控制权和定制性。开源和定制模型提供增强的安全性、定制性和可预测性。使用私有数据集对这些模型进行微调可以在特定任务上以更低的成本提供更好的性能。对于关键任务应用程序,它们确保更可预测和可控的行为。

- 采用能够简化基础设施工作流程同时确保隐私的工具。像BentoML 这样的平台通过简化的模型部署和迭代解决方案,加速产品上市时间。如果安全性是您组织的重中之重,请整合隐私优先的做法,例如 BYOC。这确保您的敏感数据永远不会离开您的网络边界。

- 实施混合 GPU 策略以平衡性能和成本。随着 LLMs 和多模态模型等 AI 工作负载变得更加苛刻,优化 GPU 使用至关重要。组织应考虑采用适合不同模型类型和工作负载的混合 GPU 策略。这可能涉及使用多个云提供商,以便为特定用例获取最佳定价和 GPU 选项。

- 更多资源

构建和扩展 AI 基础设施是一段复杂的旅程,但您不必独自前行。BentoML 团队随时准备通过可行的见解和专家指导,帮助您的 AI 基础设施面向未来。请查阅以下资源以加速您的成功

下载完整报告,获取深入见解和全面的数据分析。

- 联系我们的团队,获取有关实施 AI 基础设施解决方案的定制指导。

- 加入我们的 Slack 社区,与 AI 从业者和工程师交流。分享经验,获得实时支持,并及时了解 AI 基础设施的最佳实践。

- 自由构建